ستعمل شركة Blackwell Architecture على تسريع منتجات الذكاء الاصطناعي في أواخر عام 2024 – TechToday

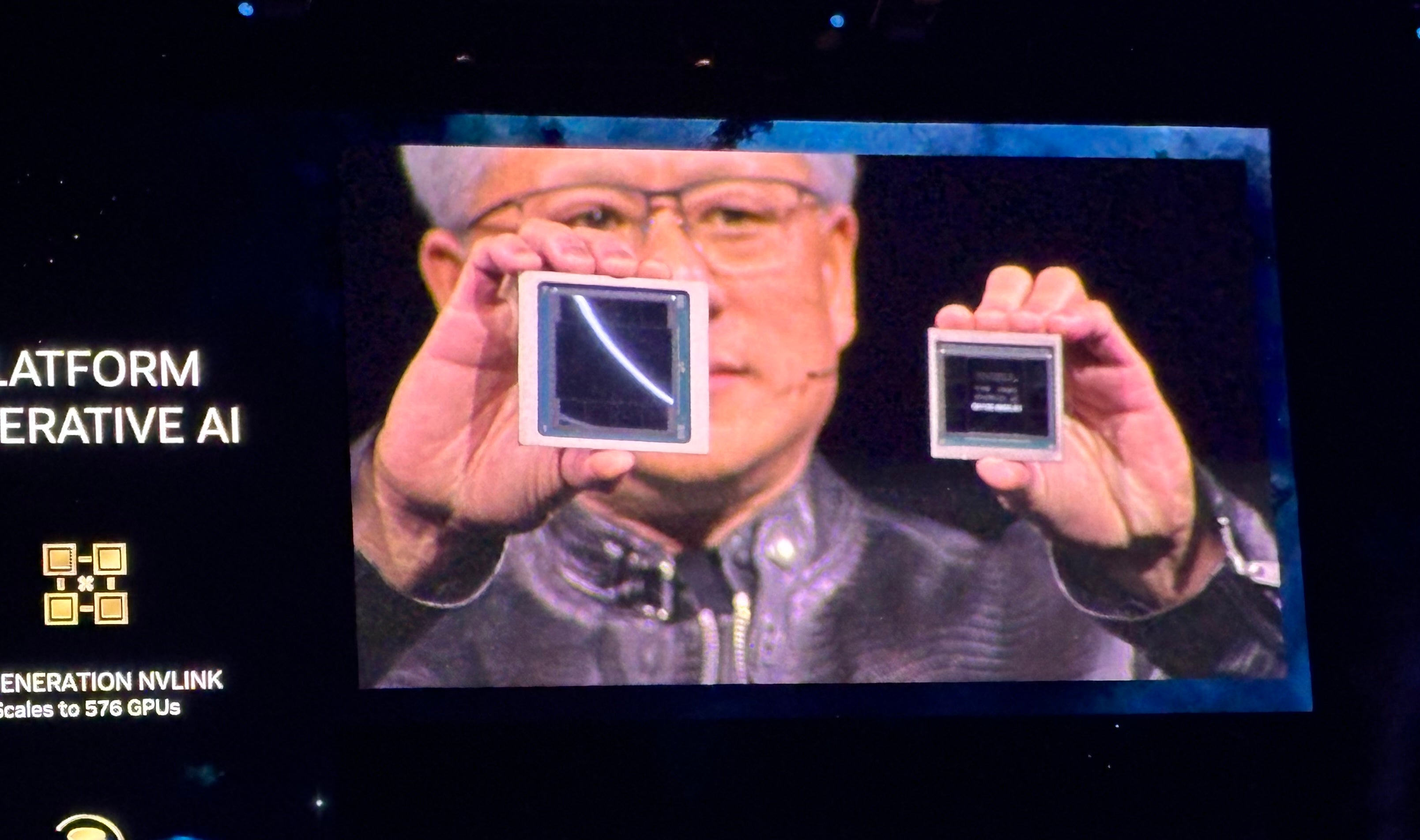

أحدث منصة GPU لـ NVIDIA هي Blackwell (الشكل أ)، والتي تخطط الشركات بما في ذلك AWS وMicrosoft وGoogle لاعتمادها في الذكاء الاصطناعي التوليدي ومهام الحوسبة الحديثة الأخرى، حسبما أعلن الرئيس التنفيذي لشركة NVIDIA Jensen Huang خلال الكلمة الرئيسية في مؤتمر NVIDIA GTC في 18 مارس في سان خوسيه، كاليفورنيا.

الشكل أ

ستدخل المنتجات المستندة إلى Blackwell السوق من شركاء NVIDIA في جميع أنحاء العالم في أواخر عام 2024. وأعلن Huang عن مجموعة طويلة من التقنيات والخدمات الإضافية من NVIDIA وشركائها، وتحدث عن الذكاء الاصطناعي التوليدي باعتباره مجرد جانب واحد من جوانب الحوسبة المتسارعة.

“عندما تصبح مسرعًا، فإن البنية التحتية الخاصة بك هي وحدات معالجة الرسومات CUDA،” قال هوانغ، في إشارة إلى CUDA، منصة الحوسبة المتوازية ونموذج البرمجة من NVIDIA. “وعندما يحدث ذلك، فهي نفس البنية التحتية المستخدمة في الذكاء الاصطناعي التوليدي.”

تتيح بلاكويل التدريب والاستدلال على النماذج اللغوية الكبيرة

وقال هوانغ إن منصة Blackwell GPU تحتوي على قالبين متصلين بواسطة 10 تيرابايت في الثانية من التوصيل البيني من شريحة إلى أخرى، مما يعني أن كل جانب يمكن أن يعمل بشكل أساسي كما لو أن “القالبين يعتقدان أنها شريحة واحدة”. يحتوي على 208 مليار ترانزستور ويتم تصنيعه باستخدام عملية NVIDIA’s 208 مليار 4NP TSMC. يتميز بعرض نطاق ترددي للذاكرة يبلغ 8 تيرابايت/ثانية و20 pentaFLOPS من أداء الذكاء الاصطناعي.

وقالت NVIDIA إنه بالنسبة للمؤسسات، فإن هذا يعني أن Blackwell يمكنها إجراء التدريب والاستدلال لنماذج الذكاء الاصطناعي التي تصل إلى 10 تريليون معلمة.

تم تعزيز بلاكويل بالتقنيات التالية:

- الجيل الثاني من TensorRT-LLM وNeMo Megatron وكلاهما من NVIDIA.

- أطر عمل لمضاعفة أحجام الحوسبة والنموذج مقارنة بمحرك المحولات من الجيل الأول.

- الحوسبة السرية مع بروتوكولات تشفير الواجهة الأصلية للخصوصية والأمان.

- محرك إلغاء ضغط مخصص لتسريع استعلامات قاعدة البيانات في تحليلات البيانات وعلوم البيانات.

وفيما يتعلق بالأمن، قال هوانغ إن محرك الموثوقية “يقوم باختبار ذاتي، واختبار داخل النظام، لكل جزء من الذاكرة الموجودة على شريحة بلاكويل وكل الذاكرة المرتبطة بها. يبدو الأمر كما لو أننا قمنا بشحن شريحة بلاكويل مع جهاز اختبار خاص بها.

ستكون المنتجات المستندة إلى Blackwell متاحة من موفري الخدمات السحابية الشركاء وشركات برنامج NVIDIA Cloud Partner وسحب سيادية مختارة.

يتبع خط Blackwell من وحدات معالجة الرسومات خط Grace Hopper من وحدات معالجة الرسومات، والذي ظهر لأول مرة في عام 2022 (الشكل ب). تقول NVIDIA إن Blackwell ستقوم بتشغيل الذكاء الاصطناعي التوليدي في الوقت الفعلي على LLMs ذات تريليون معلمة بتكلفة أقل بمقدار 25 مرة واستهلاك أقل للطاقة من خط Hopper.

الشكل ب

تقوم NVIDIA GB200 Grace Blackwell Superchip بتوصيل العديد من وحدات معالجة الرسومات Blackwell

إلى جانب وحدات معالجة الرسومات Blackwell، أعلنت الشركة عن NVIDIA GB200 Grace Blackwell Superchip، التي تربط وحدتي معالجة الرسوميات NVIDIA B200 Tensor Core بوحدة المعالجة المركزية NVIDIA Grace – مما يوفر منصة جديدة ومدمجة لاستدلال LLM. يمكن ربط NVIDIA GB200 Grace Blackwell Superchip بمنصات NVIDIA Quantum-X800 InfiniBand وSpectrum-X800 Ethernet التي أعلنت عنها الشركة حديثًا لسرعات تصل إلى 800 جيجابايت/ثانية.

سيكون GB200 متاحًا على NVIDIA DGX Cloud ومن خلال مثيلات AWS وGoogle Cloud وOracle Cloud Infrastructure في وقت لاحق من هذا العام.

يتطلع تصميم الخادم الجديد إلى نماذج الذكاء الاصطناعي ذات تريليون معلمة

يعد GB200 أحد مكونات GB200 NVL72 التي تم الإعلان عنها حديثًا، وهو تصميم خادم على نطاق حامل يجمع معًا 36 وحدة معالجة مركزية Grace و72 وحدة معالجة رسوميات Blackwell للحصول على 1.8 exaFLOPs من أداء الذكاء الاصطناعي. تتطلع NVIDIA إلى حالات الاستخدام المحتملة لبرامج LLM ضخمة ذات تريليون معلمة، بما في ذلك الذاكرة الدائمة للمحادثات والتطبيقات العلمية المعقدة والنماذج متعددة الوسائط.

يجمع GB200 NVL72 بين الجيل الخامس من موصلات NVLink (5000 كابل NVLink) وGB200 Grace Blackwell Superchip للحصول على قدر هائل من قوة الحوسبة، ويطلق عليه Huang “نظام الذكاء الاصطناعي exoflops في حامل واحد”.

وقال هوانغ: “هذا أكثر من متوسط النطاق الترددي للإنترنت… يمكننا بشكل أساسي إرسال كل شيء إلى الجميع”.

وقال هوانغ: “إن هدفنا هو التخفيض المستمر لتكلفة وطاقة الحوسبة – فهما مرتبطان بشكل مباشر مع بعضهما البعض”.

يتطلب تبريد GB200 NVL72 لترين من الماء في الثانية.

يوفر الجيل التالي من NVLink بنية مركز بيانات متسارعة

يوفر الجيل الخامس من NVLink إنتاجية ثنائية الاتجاه تبلغ 1.8 تيرابايت/ثانية لكل اتصال GPU بين ما يصل إلى 576 وحدة معالجة رسومات. تم تصميم هذا التكرار لـ NVLink ليتم استخدامه لأقوى برامج LLM المعقدة المتاحة اليوم.

وقال هوانغ: “في المستقبل، سيتم اعتبار مراكز البيانات بمثابة مصنع للذكاء الاصطناعي”.

تقديم خدمات NVIDIA Inference Microservices

هناك عنصر آخر في “مصنع الذكاء الاصطناعي” المحتمل وهو خدمة NVIDIA Inference Microservice، أو NIM، والتي وصفها هوانج بأنها “طريقة جديدة لتلقي البرامج وتعبئتها”.

إن NIMs، التي تستخدمها NVIDIA داخليًا، هي عبارة عن حاويات يمكن من خلالها تدريب ونشر الذكاء الاصطناعي التوليدي. تتيح NIMs للمطورين استخدام واجهات برمجة التطبيقات (APIs) وNVIDIA CUDA وKubernetes في حزمة واحدة.

انظر: بايثون باقية لغة البرمجة الأكثر شعبية وفقا لمؤشر TIOBE. (تك ريبابليك)

وقال هوانغ إنه بدلاً من كتابة التعليمات البرمجية لبرمجة الذكاء الاصطناعي، يمكن للمطورين “تجميع فريق من الذكاء الاصطناعي” الذي يعمل على العملية داخل NIM.

قال هوانغ: “نريد أن نبني روبوتات الدردشة – مساعدي الذكاء الاصطناعي – التي تعمل جنبًا إلى جنب مع مصممينا”.

تتوفر NIMs بدءًا من 18 مارس. ويمكن للمطورين تجربة NIMs مجانًا وتشغيلها من خلال اشتراك NVIDIA AI Enterprise 5.0.

إعلانات رئيسية أخرى من NVIDIA في GTC 2024

أعلن Huang عن مجموعة واسعة من المنتجات والخدمات الجديدة عبر الحوسبة المتسارعة والذكاء الاصطناعي التوليدي خلال الكلمة الرئيسية لـ NVIDIA GTC 2024.

أعلنت NVIDIA عن مكتبة cuPQC، وهي مكتبة تستخدم لتسريع التشفير ما بعد الكمي. يمكن للمطورين الذين يعملون على التشفير ما بعد الكمي التواصل مع NVIDIA للحصول على تحديثات حول التوفر.

تعمل سلسلة محولات الشبكة X800 من NVIDIA على تسريع البنية التحتية للذكاء الاصطناعي. على وجه التحديد، تحتوي سلسلة X800 على محولات NVIDIA Quantum-X800 InfiniBand أو NVIDIA Spectrum-X800 Ethernet ومحول NVIDIA Quantum Q3400 وNVIDIA ConnectXR-8 SuperNIC. ستكون مفاتيح X800 متاحة في عام 2025.

تشمل الشراكات الرئيسية المفصلة خلال الكلمة الرئيسية لـ NVIDIA ما يلي:

- ستكون منصة الذكاء الاصطناعي الكاملة من NVIDIA متاحة على Oracle’s Enterprise AI بدءًا من 18 مارس.

- ستوفر AWS إمكانية الوصول إلى مثيلات Amazon EC2 المستندة إلى وحدة معالجة الرسومات NVIDIA Grace Blackwell وNVIDIA DGX Cloud مع أمان Blackwell.

- ستقوم NVIDIA بتسريع Google Cloud من خلال منصة الحوسبة NVIDIA Grace Blackwell AI وخدمة NVIDIA DGX Cloud، القادمة إلى Google Cloud. لم تؤكد جوجل بعد تاريخ التوفر، على الرغم من أنه من المحتمل أن يكون في أواخر عام 2024. بالإضافة إلى ذلك، فإن منصة DGX Cloud التي تعمل بنظام NVIDIA H100 متاحة بشكل عام على Google Cloud اعتبارًا من 18 مارس.

- ستستخدم Oracle NVIDIA Grace Blackwell في OCI Supercluster وOCI Compute وNVIDIA DGX Cloud على Oracle Cloud Infrastructure. تتوفر بعض خدمات الذكاء الاصطناعي السيادية المشتركة بين Oracle-NVIDIA اعتبارًا من 18 مارس.

- ستتبنى Microsoft شريحة NVIDIA Grace Blackwell Superchip لتسريع Azure. يمكن توقع التوفر في وقت لاحق من عام 2024.

- ستستخدم Dell البنية التحتية للذكاء الاصطناعي ومجموعة برامج NVIDIA لإنشاء Dell AI Factory، وهو حل مؤسسي متكامل للذكاء الاصطناعي، متاح اعتبارًا من 18 مارس من خلال القنوات التقليدية وDell APEX. وفي وقت غير معلوم في المستقبل، ستستخدم Dell شريحة NVIDIA Grace Blackwell Superchip كأساس لمقياس الرف، والبنية عالية الكثافة والمبردة بالسوائل. وستكون Superchip متوافقة مع خوادم PowerEdge من Dell.

- ستضيف SAP إمكانات الجيل المعزز للاسترجاع من NVIDIA إلى مساعد الطيار Joule. بالإضافة إلى ذلك، ستستخدم SAP NVIDIA NIMs والخدمات المشتركة الأخرى.

وقال هوانغ: “إن الصناعة بأكملها تستعد لبلاكويل”.

منافسين لشرائح الذكاء الاصطناعي من NVIDIA

تتنافس NVIDIA بشكل أساسي مع AMD وIntel فيما يتعلق بتوفير الذكاء الاصطناعي للمؤسسات. تعمل Qualcomm وSambaNova وGroq ومجموعة واسعة من موفري الخدمات السحابية في نفس المساحة فيما يتعلق بالاستدلال والتدريب على الذكاء الاصطناعي التوليدي.

تتمتع AWS بمنصات التدريب والاستدلال الخاصة بها: Inferentia وTrainium. بالإضافة إلى الشراكة مع NVIDIA بشأن مجموعة واسعة من المنتجات، تمتلك Microsoft شريحة خاصة بها للتدريب على الذكاء الاصطناعي والاستدلال: Maia 100 AI Accelerator في Azure.

تنصل: دفعت NVIDIA تكاليف تذكرة الطيران والإقامة وبعض الوجبات في حدث NVIDIA GTC الذي عقد في الفترة من 18 إلى 21 مارس في سان خوسيه، كاليفورنيا.